Meta-Tags sind so genannte kleine Textausschnitte die eine bestimmte Funktion erfüllen. Es gibt mehrere Meta-Tags die sich im Kopfbereich (<head>) des HTML-Quellcodes befinden. Wie man sie in WordPress einfügt steht in diesem Artikel.

Meta-Tags

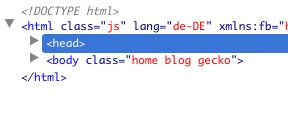

Sehen Sie sich Ihre Website an in dem Sie die Entwickler-Tools des Browsers öffnen. Dort können Sie jeden Bereich eines HTML-Quellcodes bequem einzeln aufklappen:

Die wichtigsten Meta-Tags sind:

<meta content="Eine Beschreibung der Seite" name="description" />

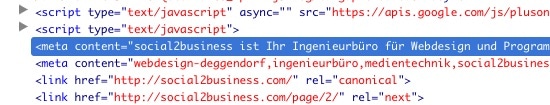

Die Meta-Description nehmen Suchmaschine meist zur Anzeige bei den Suchtreffern an. Das passiert jedoch nicht immer.

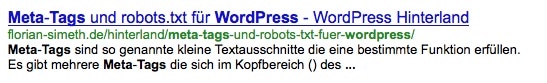

Snippet-Vorschau <title>Der Titel der Seite</title>

Wie der Name schon sagt, wird er nicht nur im Browser-Kopfbereich angezeigt sondern auch bei den Suchmaschinen in den Suchtreffern (siehe Bild oben).<link href="http://ihreseite.com/unterseite.html" rel="canonical" />

Es kann natürlich vorkommen, dass manche Seiten sich anhand eines einfachen Parameters verändern können. Das ist zum Beispiel bei Onlineshops ganz oft der Fall. Wird die gleiche Seite mit anderer Sortierung aufgerufen, ändert sich scheinbar sofort der Inhalt der Seite. Suchmaschinen können oft nicht unterscheiden ob es sich hierbei um separate Seiten (mit gleichem Inhalt) oder aber um eine Seite mit neuem Inhalt handelt. Der kanonische Link zeigt dann zurück zur ursprünglichen Seite. Beispiel: Sie befinden sich auf der Seite meinmotorshop-xy.com/helme?sortierung=preis . Der Canonical-Link muss dann auf meinmotorshop-xy.com/helme zeigen, da er denselben Inhalt enthält. So wird doppelter Inhalt ausgeschlossen.<meta content="keyword1, keyword 2, keyword, usw." name="keywords">

Früher konnte man hier alle möglichen Keywords eintragen, die man sich wünschte. Meist war der Eintrag im Kopfbereich bei Websites länger als der eigentliche Inhalt. Früher funktionierte das auch. Die Suchmaschinen werteten diesen Meta-Tag unglaublich positiv. Seitdem der Meta-Tag aber von vielen Webmastern missbräuchlich verwendet wurde findet er kaum noch Verwendung bei den großen Suchmaschinen und kann schon fast vernachlässigt werden. Wenn er auf Ihrer Website nicht vorkommt ist es deshalb auch nicht so schlimm.<meta name="robots" content="noindex,follow"/>

Der Meta-Tag „Robots“ gibt bestimmte Befehle an die Suchmaschinen weiter und teilt ihnen mit, was mit der aktuell vorliegenden Seite geschehen soll. Dabei bedeutet:- index: Die Seite soll indiziert werden.

- noindex: Die Seite soll nicht indiziert werden.

- follow: Den Links die auf dieser Seite gefunden werde bitte folgen und ebenfalls durchsuchen.

- nofollow: Den Links auf dieser Seite nicht folgen und nicht crawlen.

- all: Die Seite soll indiziert werden und allen Links soll gefolgt werden.

- Darüber hinaus sind natürlich auch zwischen allen Möglichkeiten wählen. Zum Beispiel: „noindex, follow“. Also die Suchmaschine anweisen, die Seite nicht zu indizieren aber den Links zu folgen.

- Es gibt noch weitere HTML-Head-Tags die Sie je nach Vorhaben anders einsetzen können. Weitere Informationen finden Sie zum Beispiel hier: https://wiki.selfhtml.org/wiki/HTML/Kopfdaten/meta

Wichtig ist, dass Sie jede einzelne Seite mit ihren eigenen Meta-Tags ausrüsten. Das WordPress-Plugin „Wordpress SEO by Yoast“ hilft Ihnen genau das zu tun. Schreiben Sie einen Artikel oder erstellen Sie eine neue Seite und Sie erhalten unter der Eingabemaske schnell und bequem weitere Eingabemöglichkeiten für die Meta-Tags:

Toll ist dabei, dass das Plugin Sie sofort über „YES“ und „No“ darauf hinweist, was richtig gemacht wurde und was nicht.

Übrigens: Sollte das Plugin bei Ihnen nicht sichtbar sein, können Sie es oben rechts über die Funktion „Optionen einblenden“ mit einem Klick aktivieren.

Die robots.txt

Die robots.txt ist eine kleine Textdatei die sich im Oberverzeichnis der Website befindet, also zum Beispiel unter www.meine-xy-seite.de/robots.txt. Alle Suchmaschinen rufen zuerst diese Textdatei auf (falls sie existiert) bevor sie alle Unterseiten durchsuchen und in indexieren (also in den Suchindex der Suchmaschine aufnehmen).

Aber nicht nur das. Diese Datei kann dafür sorgen dass bestimmte Suchmaschinen Ihre Seite nicht durchsuchen dürfen.

Zusätzlich wird es – ganz im Gegensatz zu den Robot-Meta-Tag – möglich, ganze Bereiche einer Website auszuschließen.

Ein einzelner Datensatz der robots.txt besteht immer aus zwei Bereichen:

- Einer „User-agent“-Anweisung damit klar wird, welche Suchmaschine betroffen ist.

- Und eine oder mehrere „Allow“- oder „Disallow“-Zeilen.

Sehen Sie sich einfach einmal die robots.txt-Dateien verschiedener Websites an. Beispielsweise Amazon (http://www.amazon.de/robots.txt) oder Stiftung Warentest (http://www.test.de/robots.txt).

Hier einige Beispiele:

User-agent: * Allow: /

Bedeutet: Jede Suchmaschine erhält Zugriff auf alle Unterseiten.

User-agent: ia_archiver Disallow: /

Bedeutet: Der Crawler von archive.org erhält keinen Zugriff auf irgendwelche Inhalte der Website.

Für WordPress findet man im Internet oft auch folgende Angaben:

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: /comments Disallow: /category/* Disallow: */trackback Disallow: */comments Disallow: /*?* Disallow: /*? Allow: /wp-content/uploads

Dabei steht der Stern (*) für einen Platzhalter. Also zum Beispiel Disallow: /category/*. Das schließt alle Seiten aus, die hinter dem „category“ stehen. So wird

- meineAutoSeite.com/category/tests genauso ausgeschlossen wie

- meineAutoSeite.com/category/bwm.

Ausschließen bestimmter Seiten

Sie fragen sich jetzt, warum Sie bestimmte Seiten überhaupt ausschließen sollen? Immerhin können sogenannte Schlagwortseiten oder Kategorieseiten, wie sie WordPress automatisch anlegt, viele Fundstellen erzeugen und damit Besucher auf die Website bringen.

Das Problem ist allerdings der doppelte Inhalt der an vielen Stellen von WordPress automatisiert erstellt wird. Suchmaschinen suchen nach einzigartigen Inhalten, also keine Inhalte die so schon einmal auf irgendeine Art und Weise im Internet gefunden wurden.

Beispiel: Sie schreiben einen Artikel über den BMW 1er. Sie verknüpfen ihn mit folgenden Wörtern (sogenannten Tags):

- BMW,

- BMW 1er,

- 1er BMW,

- BMW 1 Test,

WordPress erzeugt dann automatisch folgende Unterseiten:

- ihreAutoSeiteXY.com/tag/bmw

- ihreAutoSeiteXY.com/tag/bmw-1er

- ihreAutoSeiteXY.com/tag/1er-bmw

- ihreAutoSeiteXY.com/tag/bmw-1-test

Auf jeder dieser Seiten befindet sich (je nach Theme) entweder der komplette Inhalt oder ein kurzer Anrisstext des ursprünglich geschriebenen Artikels. Unter Umständen benutzen Sie einige dieser Keywörter aber nie wieder. Dann befindet auf fünf Unterseiten immer derselbe Inhalt. Sie haben Ihren Artikel also nicht nur dupliziert sondern verfünffacht. Die Suchmaschinen wissen dann nicht welcher denn der Ursprungsartikel war.

Das ist ein Problem und kann zu einer Abwertung der gesamten Website führen.

Sie sollten also entweder alle Tags- oder alle Kategorie-Unterseiten indexieren lassen. Nicht beides gleichzeitig. Es sei denn, Sie pflegen Ihre Website so gut, dass Sie von allen Tags und Kategorien nur eine handvoll einsetzen. Was ja letztendlich auch Sinn macht und insgesamt mehr Struktur in die Website bringt.

Die humans.txt

Seit geraumer Zeit gibt es eine Initiative von und für Webseitenbesitzer. Die humans.txt (http://humanstxt.org). Sie soll dazu dienen die Leute hinter den Websites kenntlich zu machen. Leider ist dieses Dateiformat noch nicht standardisiert und vielleicht wird das (wie auch bei der robots.txt) nie passieren. Sie können die Datei aber getrost hochladen. Schaden tut das nie. Und vor allem können Sie zugleich eine Backlink der Website abstauben, weil es nämlich möglich ist, seine humans.txt auf der Website der Initiative einzutragen.

Die humans.txt ist wie folgt aufgebaut:

/* TEAM */ Your title: [Ihr Name] Site: [E-Mail Adresse oder Link zum Kontaktformular] Twitter: [Twitter-Benutzername] Location: [Stadt, Land] /* THANKS */ Name: [Name oder Internet-Adresse] /* SITE */ Last update: [YYYY/MM/DD] Standards: [HTML5, CSS3,..] Components: [jQuery] Software: [Software die zur Erstellung der Website genutzt wurde]

Ersetzen Sie dabei alle Elemente in eckigen Klammern durch Ihre eigenen Angaben. Eine Menge Beispiele finden Sie hier: http://humanstxt.org/humans

Wie man sieht erfüllt die Humans.txt mehrere Zwecke. Zum einen stellt es den Inhalt der Website, deren Autoren und Technologien noch einmal kurz und knackig dar und zum anderen gibt es den Suchmaschinen weitere Anhaltspunkte. Etwa Links auf andere Plattformen wie Twitter.